با پیشرفتهای سریع در زمینه هوش مصنوعی (AI) و یادگیری ماشین، مدلهای پیچیدهای توسعه یافتهاند که توانایی انجام وظایف مختلفی را دارند، از جمله تشخیص تصویر، پردازش زبان طبیعی و پیشبینیهای اقتصادی. با این حال، یکی از چالشهای اصلی این مدلها، عدم شفافیت و تفسیرپذیری آنهاست. به عبارت دیگر، درک اینکه چگونه و چرا یک مدل خاص به یک نتیجه خاص میرسد، برای بسیاری از کاربران و محققان دشوار است. این مقاله به بررسی اهمیت شفافیت و تفسیرپذیری در مدلهای هوش مصنوعی، چالشها و روشهای موجود برای بهبود این ویژگیها میپردازد.

1. اهمیت شفافیت و تفسیرپذیری

1.1. اعتماد و پذیرش

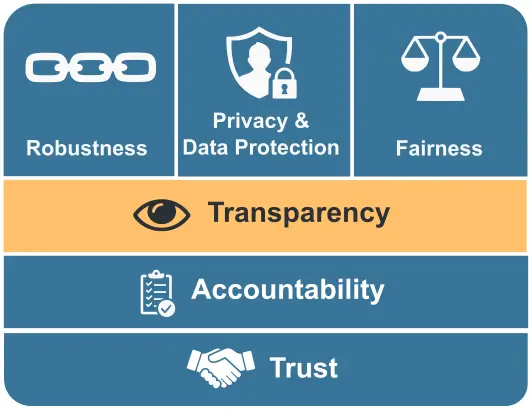

شفافیت و تفسیرپذیری مدلهای هوش مصنوعی برای ایجاد اعتماد در کاربران و ذینفعان ضروری است. زمانی که کاربران قادر به درک نحوه عملکرد یک مدل و دلایل تصمیمگیری آن باشند، احتمال بیشتری وجود دارد که به آن اعتماد کنند. این اعتماد میتواند به پذیرش گستردهتر فناوریهای هوش مصنوعی در صنایع مختلف منجر شود.

1.2. شناسایی و اصلاح خطاها

تفسیرپذیری به محققان و توسعهدهندگان این امکان را میدهد که خطاها و مشکلات موجود در مدلها را شناسایی کنند. اگر یک مدل به نتایج نادرستی دست یابد، تفسیرپذیری میتواند به شناسایی عواملی که باعث این نتایج شدهاند کمک کند و به اصلاح آنها منجر شود.

1.3. رعایت مقررات و اخلاق

با توجه به افزایش استفاده از هوش مصنوعی در حوزههای حساس مانند پزشکی، مالی و حقوقی، شفافیت و تفسیرپذیری به رعایت مقررات و اصول اخلاقی کمک میکند. نهادهای نظارتی ممکن است نیاز داشته باشند تا دلایل تصمیمات مدلهای هوش مصنوعی را بررسی کنند، به ویژه زمانی که این تصمیمات تأثیرات قابل توجهی بر زندگی انسانها دارند.

2. چالشهای شفافیت و تفسیرپذیری

2.1. پیچیدگی مدلها

مدلهای هوش مصنوعی، به ویژه مدلهای یادگیری عمیق، معمولاً بسیار پیچیده هستند و شامل میلیونها پارامتر میباشند. این پیچیدگی باعث میشود که درک نحوه عملکرد آنها دشوار باشد. به عنوان مثال، شبکههای عصبی عمیق میتوانند به صورت غیرخطی و با وابستگیهای پیچیده به دادهها عمل کنند، که این امر تفسیر نتایج را چالشبرانگیز میکند.

2.2. عدم استانداردسازی

در حال حاضر، هیچ استاندارد واحدی برای تفسیرپذیری و شفافیت مدلهای هوش مصنوعی وجود ندارد. این عدم استانداردسازی میتواند به سردرگمی در ارزیابی و مقایسه مدلها منجر شود و توسعهدهندگان را در انتخاب روشهای مناسب برای تفسیر نتایج خود دچار مشکل کند.

2.3. تضاد بین دقت و تفسیرپذیری

در برخی موارد، مدلهای پیچیدهتر ممکن است دقت بالاتری داشته باشند، اما تفسیرپذیری کمتری ارائه دهند. به عنوان مثال، مدلهای یادگیری عمیق معمولاً در مقایسه با مدلهای سادهتر مانند درخت تصمیم یا رگرسیون خطی دقت بیشتری دارند، اما تفسیر نتایج آنها دشوارتر است. این تضاد میتواند چالشهایی برای توسعهدهندگان ایجاد کند که باید بین دقت و تفسیرپذیری انتخاب کنند.

3. روشهای بهبود شفافیت و تفسیرپذیری

3.1. مدلهای قابل تفسیر

استفاده از مدلهای قابل تفسیر مانند درختهای تصمیم، رگرسیون خطی و مدلهای مبتنی بر قوانین میتواند به بهبود شفافیت کمک کند. این مدلها به راحتی قابل درک هستند و میتوانند به کاربران توضیحات واضحی درباره نحوه تصمیمگیری خود ارائه دهند.

3.2. تکنیکهای تفسیرپذیری

تعدادی از تکنیکها و ابزارها برای تفسیر نتایج مدلهای پیچیده وجود دارد. برخی از این تکنیکها عبارتند از:

- LIME (Local Interpretable Model-agnostic Explanations): این روش به تحلیل محلی مدلهای پیچیده میپردازد و سعی میکند با ایجاد مدلهای سادهتر در اطراف نقاط داده خاص، توضیحات قابل فهمی ارائه دهد.

- SHAP (SHapley Additive exPlanations): این تکنیک به توزیع سهم هر ویژگی در پیشبینی نهایی مدل میپردازد و به کاربران کمک میکند تا بفهمند کدام ویژگیها تأثیر بیشتری بر تصمیمات مدل دارند.

- تجزیه و تحلیل حساسیت: این روش به بررسی تأثیر تغییرات در ورودیها بر خروجیهای مدل میپردازد و میتواند به شناسایی ویژگیهای کلیدی کمک کند.

3.3. آموزش و آگاهی

آموزش کاربران و ذینفعان درباره نحوه عملکرد مدلهای هوش مصنوعی و تفسیر نتایج آنها میتواند به افزایش شفافیت کمک کند. برگزاری کارگاهها و دورههای آموزشی میتواند به کاربران کمک کند تا با تکنیکهای تفسیر و ابزارهای موجود آشنا شوند.

4. آینده شفافیت و تفسیرپذیری

آینده شفافیت و تفسیرپذیری در هوش مصنوعی به شدت به پیشرفتهای فناوری و تحقیقات در این زمینه وابسته است. با افزایش استفاده از هوش مصنوعی در حوزههای حساس، انتظار میرود که نیاز به شفافیت و تفسیرپذیری بیشتر شود. همچنین، توسعه ابزارها و تکنیکهای جدید برای بهبود تفسیر نتایج و شفافیت مدلها میتواند به افزایش اعتماد عمومی و پذیرش فناوریهای هوش مصنوعی کمک کند.

نتیجهگیری

شفافیت و تفسیرپذیری مدلهای هوش مصنوعی به عنوان یک ضرورت در عصر فناوری اطلاعات و هوش مصنوعی شناخته میشود. این ویژگیها نه تنها به ایجاد اعتماد و پذیرش فناوری کمک میکنند، بلکه به شناسایی و اصلاح خطاها و رعایت اصول اخلاقی نیز کمک مینمایند. با وجود چالشهای موجود، استفاده از مدلهای قابل تفسیر، تکنیکهای تفسیرپذیری و آموزش کاربران میتواند به بهبود شفافیت و تفسیرپذیری مدلهای هوش مصنوعی کمک کند. در نهایت، این تلاشها میتوانند به توسعه فناوریهای هوش مصنوعی هوشمندتر و مؤثرتر منجر شوند که به نفع جامعه و کاربران خواهد بود.

برای خواندن مطالب بیشتر به وبلاگ سر بزنید.