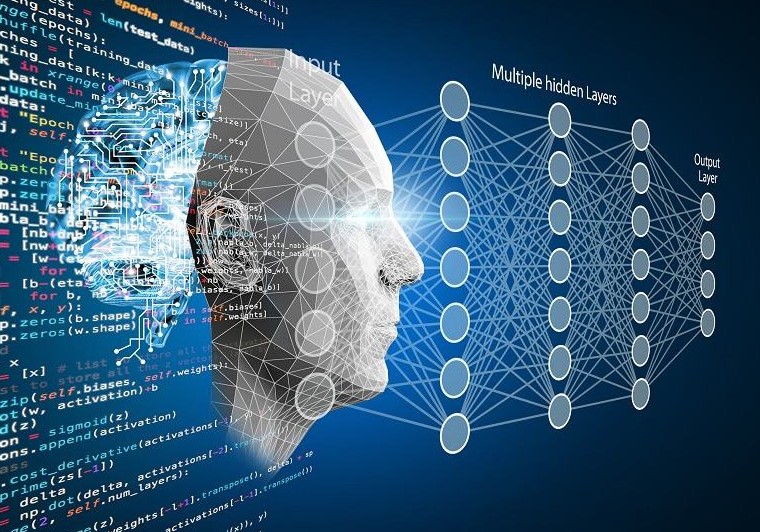

یادگیری عمیق (Deep Learning) به عنوان یکی از زیرمجموعههای هوش مصنوعی و یادگیری ماشین، در سالهای اخیر به طور چشمگیری در زمینههای مختلفی از جمله بینایی کامپیوتری، پردازش زبان طبیعی، و تشخیص الگوها پیشرفت کرده است. با این حال، یکی از چالشهای عمدهای که در استفاده از مدلهای یادگیری عمیق وجود دارد، عدم تفسیرپذیری این مدلها است. این مقاله به بررسی مفهوم یادگیری عمیق تفسیرپذیر، ضرورت آن، و چالشهای مرتبط با آن میپردازد.

1.مفهوم یادگیری عمیق تفسیرپذیر

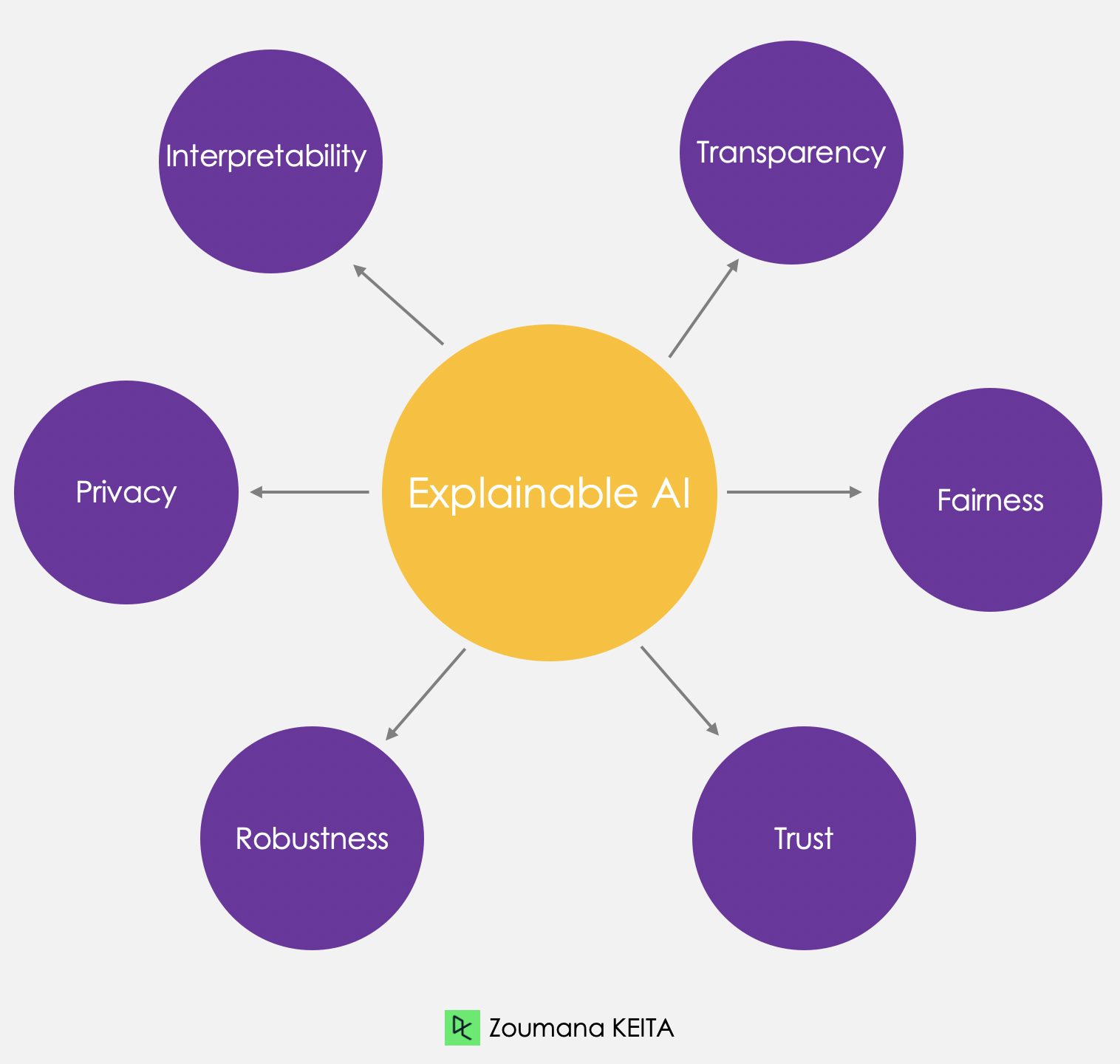

یادگیری عمیق تفسیرپذیر به معنای توانایی درک و توضیح نحوه عملکرد مدلهای یادگیری عمیق است. به عبارت دیگر، این مفهوم به ما کمک میکند تا بفهمیم مدلها چگونه تصمیمات خود را اتخاذ میکنند و چه ویژگیهایی در دادهها بر نتایج تأثیر میگذارند. تفسیرپذیری به ویژه در حوزههایی مانند پزشکی، مالی، و حقوقی اهمیت دارد، زیرا در این زمینهها، کاربران نیاز دارند تا دلایل پشت تصمیمات مدلها را درک کنند.

2.ضرورت یادگیری عمیق تفسیرپذیر

- اعتماد و پذیرش:

- یکی از بزرگترین موانع در پذیرش مدلهای یادگیری عمیق، عدم اعتماد به این مدلها است. اگر کاربران نتوانند دلایل تصمیمات مدل را درک کنند، احتمالاً از استفاده از آنها در برنامههای حساس و حیاتی خود پرهیز خواهند کرد. برای مثال، در پزشکی، پزشکان باید قادر به درک دلایل پیشبینیهای مدلهای هوش مصنوعی باشند تا بتوانند آنها را در تصمیمگیریهای بالینی خود به کار ببرند.

- مسئولیتپذیری:

- در حوزههایی مانند پزشکی و حقوق، تصمیمات مدلهای هوش مصنوعی میتواند تأثیرات جدی بر زندگی انسانها داشته باشد. بنابراین، وجود تفسیرپذیری در این مدلها به مسئولیتپذیری و شفافیت کمک میکند. به عنوان مثال، در یک سیستم تشخیص بیماری، اگر مدلی پیشبینی کند که یک بیمار به بیماری خاصی مبتلا است، پزشک باید بتواند بفهمد که کدام ویژگیها (مانند سن، جنسیت، یا علائم بالینی) بر این پیشبینی تأثیرگذار بودهاند.

- تشخیص خطاها:

- تفسیرپذیری به محققان و مهندسان کمک میکند تا نقاط ضعف و خطاهای مدلها را شناسایی کنند و به بهبود عملکرد آنها بپردازند. به عنوان مثال، اگر یک مدل در تشخیص تصاویر دچار خطا شود، تفسیرپذیری میتواند نشان دهد که کدام ویژگیها باعث این خطا شدهاند و چگونه میتوان مدل را بهبود بخشید.

3.چالشهای یادگیری عمیق تفسیرپذیر

- پیچیدگی مدلها:

- مدلهای یادگیری عمیق معمولاً بسیار پیچیده و دارای لایههای متعدد هستند. این پیچیدگی باعث میشود که تفسیر عملکرد آنها دشوار باشد. به عنوان مثال، در شبکههای عصبی عمیق، تعداد زیادی از پارامترها و وزنها وجود دارد که هر کدام میتوانند بر خروجی نهایی تأثیر بگذارند.

- تجزیه و تحلیل دادههای بزرگ:

- با توجه به حجم بالای دادههایی که مدلهای یادگیری عمیق با آنها کار میکنند، تجزیه و تحلیل و تفسیر این دادهها میتواند چالشبرانگیز باشد. به عنوان مثال، در یک سیستم تشخیص چهره، دادههای ورودی میتوانند شامل میلیونها تصویر باشند و تفسیر اینکه کدام ویژگیها باعث شناسایی یک چهره خاص میشوند، میتواند دشوار باشد.

- عدم توافق بر سر معیارهای تفسیرپذیری:

- هیچ استاندارد واحدی برای تفسیرپذیری وجود ندارد. این موضوع باعث میشود که نتایج تفسیرپذیری مدلها ممکن است متفاوت باشد و در برخی موارد حتی متناقض به نظر برسد. به عنوان مثال، یک روش ممکن است نشان دهد که یک ویژگی خاص مهم است، در حالی که روش دیگری ممکن است نشان دهد که آن ویژگی تأثیر کمی دارد.

4.روشهای تفسیرپذیری در یادگیری عمیق

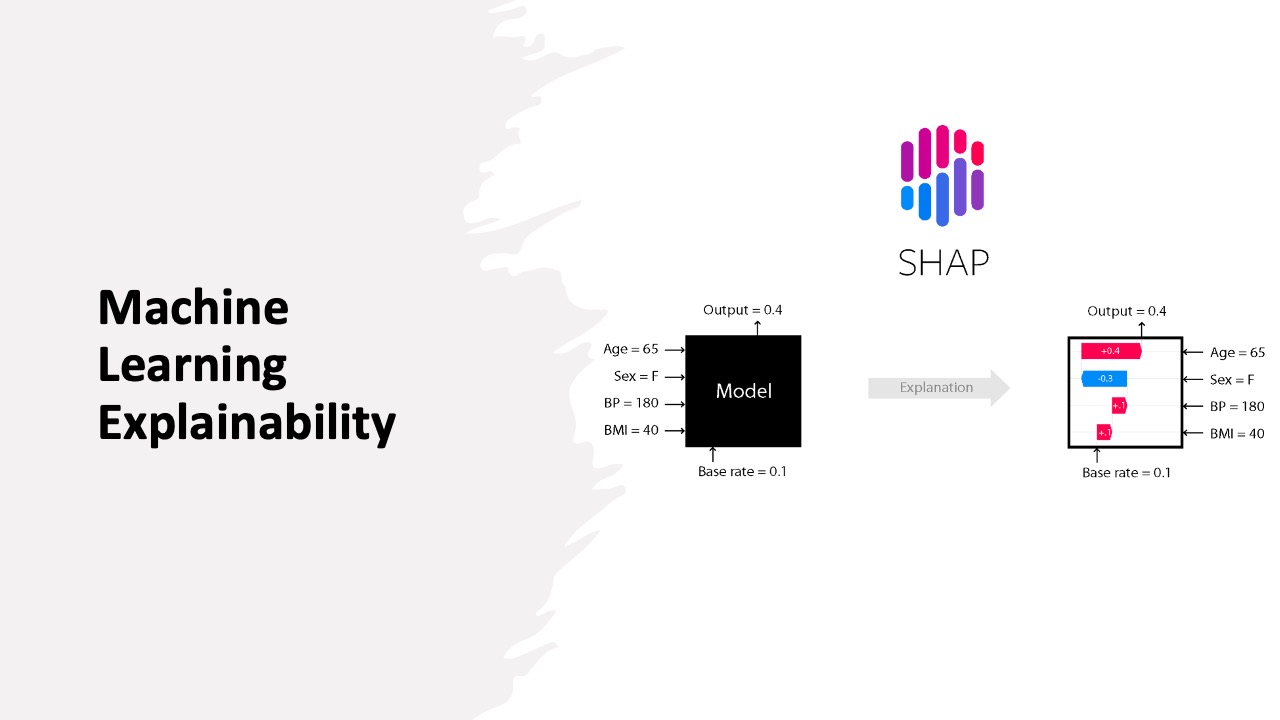

- روشهای مبتنی بر توضیح (Explanatory Methods):

- این روشها شامل تکنیکهایی مانند LIME (Local Interpretable Model-agnostic Explanations) و SHAP (SHapley Additive exPlanations) هستند که به تحلیل تأثیر ویژگیهای مختلف بر تصمیمات مدل کمک میکنند. LIME به طور محلی تصمیمات مدل را تفسیر میکند و به کاربران این امکان را میدهد که بفهمند چرا یک پیشبینی خاص انجام شده است. SHAP از نظریه بازیها برای توزیع تأثیر ویژگیها استفاده میکند و نتایج قابل تفسیر و دقیقی ارائه میدهد.

- تجزیه و تحلیل حساسیت (Sensitivity Analysis):

- این روش به بررسی چگونگی تأثیر تغییرات در ورودیها بر خروجی مدل میپردازد و میتواند به درک بهتر عملکرد مدل کمک کند. با تغییر دادن ویژگیهای ورودی و مشاهده تغییرات در خروجی، میتوان فهمید که کدام ویژگیها بیشترین تأثیر را دارند.

- مدلهای تفسیرپذیر:

- استفاده از مدلهای سادهتر و تفسیرپذیر مانند درختهای تصمیم و رگرسیون خطی به عنوان پایهای برای مقایسه با مدلهای پیچیدهتر میتواند مفید باشد. این مدلها به راحتی قابل تفسیر هستند و میتوانند به عنوان مرجع برای درک بهتر عملکرد مدلهای پیچیدهتر عمل کنند.

نمونههای کاربردی یادگیری عمیق تفسیرپذیر

- پزشکی:

- در تشخیص بیماریها، استفاده از مدلهای تفسیرپذیر میتواند به پزشکان کمک کند تا تصمیمات خود را بر اساس دلایل مشخص و قابل درک اتخاذ کنند. به عنوان مثال، در یک مطالعه، محققان از مدلهای تفسیرپذیر برای پیشبینی خطر ابتلا به دیابت استفاده کردند و توانستند ویژگیهای کلیدی مانند سطح قند خون و سن را شناسایی کنند.

- مالی:

- در صنعت مالی، تفسیرپذیری مدلها میتواند به شناسایی ریسکهای اعتباری کمک کند. به عنوان مثال، یک مدل پیشبینی ورشکستگی میتواند به تحلیلگران این امکان را بدهد که بفهمند کدام ویژگیها (مانند نسبت بدهی به درآمد) بیشترین تأثیر را بر پیشبینی دارند.

- بازاریابی:

- در بازاریابی، تفسیرپذیری میتواند به تحلیلگران کمک کند تا بفهمند چرا یک کمپین تبلیغاتی موفق یا ناموفق بوده است. با استفاده از مدلهای تفسیرپذیر، میتوان ویژگیهای کلیدی مشتریان را شناسایی کرد که بر نتایج کمپین تأثیر گذاشتهاند.

نتیجهگیری

یادگیری عمیق تفسیرپذیر یک حوزه تحقیقاتی مهم و در حال رشد است که به ما کمک میکند تا از قدرت مدلهای یادگیری عمیق بهرهبرداری کنیم، در حالی که درک بهتری از نحوه عملکرد آنها داریم. با توجه به نیاز روزافزون به شفافیت و مسئولیتپذیری در استفاده از هوش مصنوعی، توسعه روشها و تکنیکهای جدید برای تفسیرپذیری مدلها ضروری است. این امر نه تنها به افزایش اعتماد کاربران کمک میکند، بلکه میتواند به بهبود مستمر و کارآمدی مدلهای یادگیری عمیق منجر شود.

برای خواندن مطالب بیشتر به وبلاگ سر بزنید.