ترنسفورمرها (Transformers) به عنوان یکی از پیشرفتهترین و تأثیرگذارترین معماریهای یادگیری عمیق در زمینه پردازش زبان طبیعی (NLP) و سایر حوزهها شناخته میشوند. این معماری در سال 2017 توسط محققان گوگل در مقالهای به نام “Attention is All You Need” معرفی شد و به سرعت به استانداردی در یادگیری ماشین تبدیل گردید. در این مقاله، به بررسی ساختار، عملکرد، کاربردها و تأثیرات ترنسفورمرها خواهیم پرداخت.

1. ساختار ترنسفورمرها

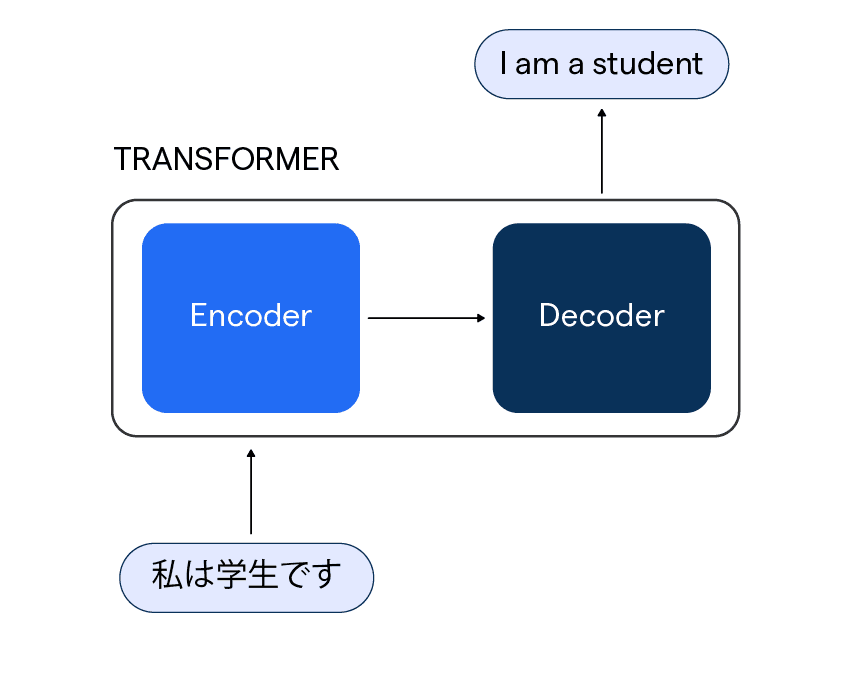

ترنسفورمرها به طور کلی شامل دو بخش اصلی هستند: Encoder و Decoder. این دو بخش به صورت زیر عمل میکنند:

1.1. Encoder

بخش Encoder وظیفه دریافت ورودی و تبدیل آن به نمایشی با ابعاد ثابت را بر عهده دارد. این بخش شامل چندین لایه است که هر لایه شامل دو زیرلایه اصلی است:

- لایه توجه (Attention Layer): این لایه به مدل اجازه میدهد تا به بخشهای مختلف ورودی توجه کند و اطلاعات مهم را استخراج کند. توجه خودمحور (Self-Attention) در این لایه به مدل کمک میکند تا وابستگیهای طولانیمدت در دادهها را شناسایی کند. این ویژگی به مدل کمک میکند تا بفهمد هر کلمه در یک جمله چگونه به کلمات دیگر وابسته است و به این ترتیب، معنای کلی جمله را بهتر درک کند.

- لایه تغییری (Feed-Forward Layer): این لایه به هر نمایه ورودی اعمال میشود و به مدل کمک میکند تا ویژگیهای پیچیدهتری را یاد بگیرد. این لایه معمولاً شامل دو تابع فعالسازی است که به مدل کمک میکند تا روابط غیرخطی را در دادهها شناسایی کند.

1.2. Decoder

بخش Decoder وظیفه تولید خروجی را بر عهده دارد. این بخش نیز شامل چندین لایه است که مشابه Encoder عمل میکند، اما به علاوه دارای یک لایه توجه اضافی است که به آن اجازه میدهد به خروجیهای قبلی خود توجه کند. این ویژگی به مدل کمک میکند تا توالیهای خروجی را به طور مؤثرتری تولید کند. در واقع، Decoder میتواند اطلاعاتی از خروجیهای قبلی را در تولید خروجیهای جدید لحاظ کند، که این امر در تولید متنهای طبیعی و معنادار بسیار مهم است.

2. عملکرد ترنسفورمرها

عملکرد ترنسفورمرها به طور عمده بر پایه مکانیزم توجه است. در این مکانیزم، هر کلمه در ورودی به سایر کلمات توجه میکند و وزنهای متفاوتی را به آنها اختصاص میدهد. این وزنها نشاندهنده اهمیت هر کلمه در تعیین معنای کلمه هدف هستند. به عنوان مثال، در جمله “او کتاب را خواند”، توجه به کلمه “کتاب” میتواند به درک بهتر این جمله کمک کند.

مکانیزم توجه به ترنسفورمرها این امکان را میدهد که وابستگیهای طولانیمدت را بهتر شناسایی کنند و به طور مؤثری اطلاعات را از ورودی به خروجی منتقل کنند. این ویژگی یکی از نقاط قوت اصلی ترنسفورمرها در مقایسه با مدلهای قبلی مانند شبکههای عصبی بازگشتی (RNN) و LSTM است.

3. کاربردهای ترنسفورمرها

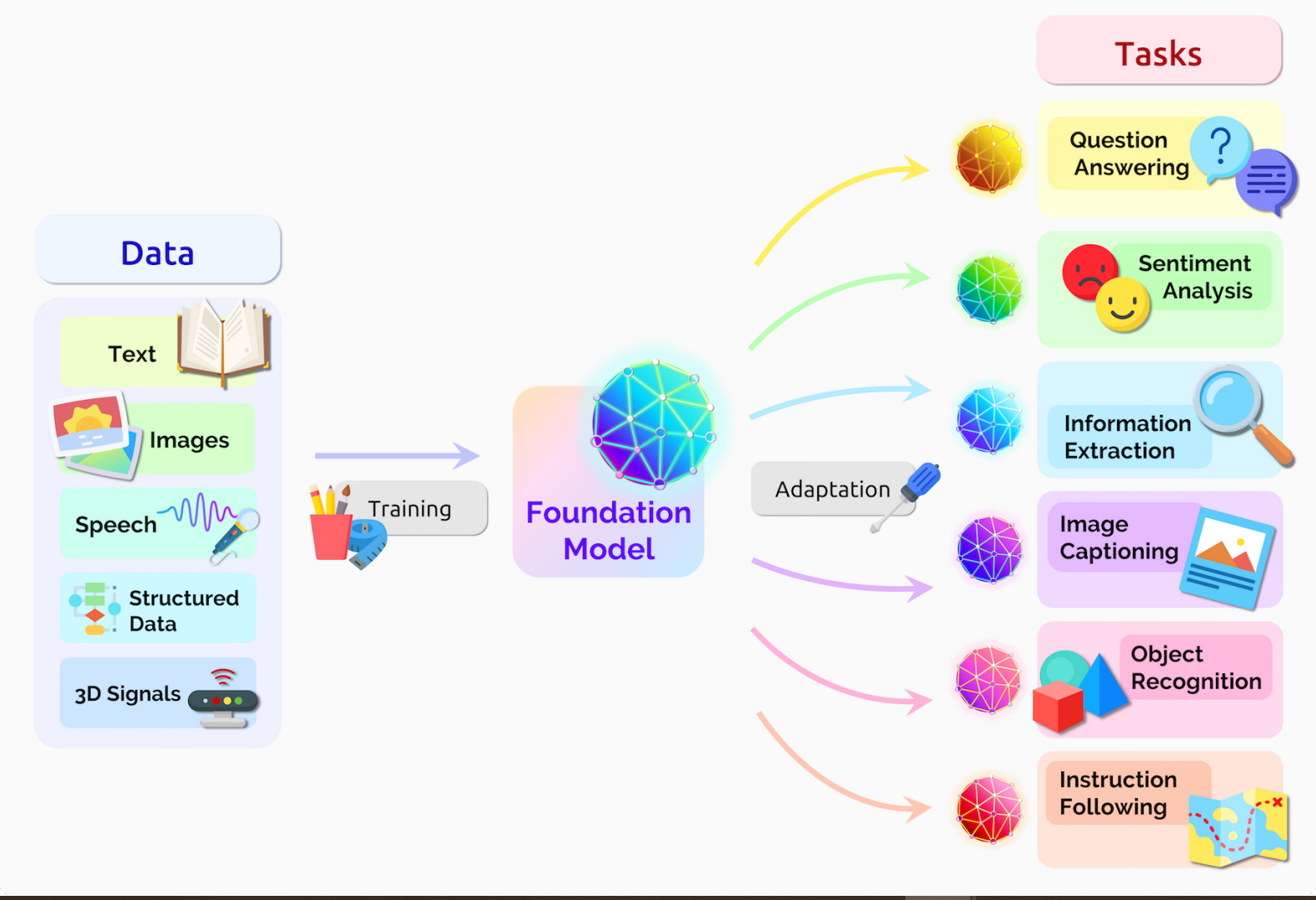

ترنسفورمرها به سرعت در زمینههای مختلفی از جمله پردازش زبان طبیعی، بینایی کامپیوتری و حتی بازیهای ویدیویی به کار گرفته شدهاند. برخی از کاربردهای اصلی آنها عبارتند از:

3.1. پردازش زبان طبیعی

- ترجمه ماشینی: ترنسفورمرها به طور گستردهای در سیستمهای ترجمه ماشینی مانند Google Translate استفاده میشوند. این مدلها میتوانند جملات را به صورت مؤثر و با دقت بالا از یک زبان به زبان دیگر ترجمه کنند. این امر به ویژه در مواقعی که نیاز به ترجمه سریع و دقیق وجود دارد، بسیار مفید است.

- تولید متن: مدلهایی مانند GPT (Generative Pre-trained Transformer) و BERT (Bidirectional Encoder Representations from Transformers) به تولید متنهای طبیعی و پاسخ به سوالات کمک میکنند. این مدلها توانایی تولید متونی با کیفیت بالا و مشابه به نوشتار انسانی را دارند و در تولید محتوا، نوشتن مقالات و پاسخ به سوالات پیچیده کاربرد دارند.

- تحلیل احساسات: ترنسفورمرها میتوانند در تحلیل احساسات و شناسایی عواطف در متون مورد استفاده قرار گیرند، به ویژه در بررسی نظرات مشتریان و بازخوردها. این کاربرد به شرکتها کمک میکند تا نظرات مشتریان را بهتر درک کنند و بهبودهای لازم را در محصولات و خدمات خود اعمال کنند.

3.2. بینایی کامپیوتری

- شناسایی تصویر: ترنسفورمرها به تازگی در حوزه بینایی کامپیوتری نیز به کار گرفته شدهاند. مدلهایی مانند Vision Transformer (ViT) به شناسایی و طبقهبندی تصاویر کمک میکنند و نتایج قابل توجهی را در رقابتهای شناسایی تصویر به دست آوردهاند. این مدلها میتوانند در تشخیص اشیاء، شناسایی چهره و حتی در کاربردهای پزشکی مانند تحلیل تصاویر پزشکی مؤثر باشند.

3.3. بازیهای ویدیویی

- هوش مصنوعی در بازیها: ترنسفورمرها میتوانند در توسعه هوش مصنوعی برای بازیهای ویدیویی به کار روند و به شخصیتهای بازی اجازه دهند تا به طور طبیعی با بازیکنان تعامل داشته باشند. این امر میتواند تجربه بازی را بهبود بخشد و به بازیکنان اجازه دهد تا با شخصیتهای بازی به شکل بهتری ارتباط برقرار کنند.

4. مزایا و چالشهای ترنسفورمرها

4.1. مزایا

- توانایی در پردازش توالیهای طولانی: ترنسفورمرها به طور مؤثری میتوانند وابستگیهای طولانیمدت را شناسایی کنند و به همین دلیل در پردازش زبان طبیعی بسیار مؤثر هستند. این ویژگی به آنها اجازه میدهد تا درک بهتری از متنهای پیچیده داشته باشند.

- موازیسازی: برخلاف RNNها، ترنسفورمرها میتوانند به صورت موازی آموزش ببینند، که این امر به کاهش زمان آموزش کمک میکند. این ویژگی به ویژه در زمانهایی که با دادههای بزرگ کار میشود، بسیار مهم است.

- دقت بالا: ترنسفورمرها در بسیاری از وظایف NLP به دقت بالایی دست یافتهاند و به استانداردهای جدیدی در این حوزه تبدیل شدهاند. این دقت بالا به آنها اجازه میدهد تا در کاربردهای مختلف به خوبی عمل کنند.

4.2. چالشها

- نیاز به دادههای بزرگ: ترنسفورمرها معمولاً نیاز به مجموعههای داده بزرگ و متنوع دارند تا به خوبی آموزش ببینند. این نیاز میتواند به چالشهایی در دسترسی به دادههای با کیفیت منجر شود.

- هزینه محاسباتی: آموزش ترنسفورمرها به منابع محاسباتی زیادی نیاز دارد و این میتواند هزینههای بالایی را به همراه داشته باشد. به همین دلیل، استفاده از این مدلها ممکن است برای برخی از سازمانها محدود باشد.

- تفسیرپذیری: با وجود دقت بالا، تفسیر نتایج مدلهای ترنسفورمر هنوز یک چالش بزرگ است و درک اینکه چرا مدلها به نتایج خاصی دست مییابند، دشوار است. این موضوع میتواند به عدم اعتماد به مدلها در برخی از کاربردها منجر شود.

5. آینده ترنسفورمرها

آینده ترنسفورمرها به شدت وابسته به پیشرفتهای فناوری و تحقیقات در زمینه هوش مصنوعی است. انتظار میرود که ترنسفورمرها در آینده بهبود یابند و به کاربردهای جدیدی در زمینههای مختلف دست یابند. همچنین، تلاشها برای کاهش هزینههای محاسباتی و بهبود تفسیرپذیری مدلها میتواند به افزایش پذیرش این فناوریها کمک کند.

5.1. توسعه مدلهای جدید

تحقیقات در حال حاضر بر روی توسعه مدلهای جدیدی متمرکز شده است که میتوانند به بهبود عملکرد ترنسفورمرها کمک کنند. به عنوان مثال، مدلهایی مانند T5 (Text-to-Text Transfer Transformer) و BART (Bidirectional and Auto-Regressive Transformers) به دنبال بهینهسازی فرآیندهای تولید و درک متن هستند.

5.2. کاربردهای چندرسانهای

انتظار میرود که ترنسفورمرها به زودی در زمینههای چندرسانهای مانند تولید ویدیو، موسیقی و هنرهای دیجیتال نیز به کار روند. این کاربردها میتوانند به ایجاد محتواهای خلاقانه و جذاب کمک کنند و به هنرمندان و تولیدکنندگان محتوا ابزارهای جدیدی ارائه دهند.

نتیجهگیری

ترنسفورمرها به عنوان یک انقلاب در پردازش زبان طبیعی و یادگیری عمیق، تأثیر عمیقی بر نحوه تعامل انسانها با فناوری داشتهاند. با ساختار منحصر به فرد و قابلیتهای پیشرفته خود، ترنسفورمرها به استانداردی در زمینه یادگیری ماشین تبدیل شدهاند و در آینده نیز انتظار میرود که به پیشرفتهای بیشتری در این حوزه منجر شوند. با این حال، چالشهای مرتبط با نیاز به دادههای بزرگ و هزینههای محاسباتی همچنان باید مورد توجه قرار گیرد. در نهایت، ترنسفورمرها میتوانند به بهبود کیفیت زندگی انسانها و ارتقاء فناوریهای نوین کمک کنند و به توسعه ابزارهای هوش مصنوعی هوشمندتر و مؤثرتر منجر شوند.

برای خواندن مطالب بیشتر به وبلاگ سر بزنید.